يعد المعالج (CPU) أو ما يعرف بوحدة المعالجة المركزية العقل المفكّر لأي جهاز كمبيوتر، فهو المسؤول عن تنفيذ العمليات الحسابية ومعالجة التعليمات والتحكم في الأوامر المرسلة إلى مختلف مكونات الحاسوب والأجهزة الطرفية المتصلة به.

ولا يقتصر وجود المعالج على أجهزة الكمبيوتر المكتبية أو المحمولة فقط، بل نجده حاضرًا في معظم الأجهزة الإلكترونية الحديثة مثل الهواتف الذكية، أجهزة الألعاب، والساعات الذكية، ما يجعله حجر الأساس لتشغيل أي نظام. فبدون المعالج لا يمكن للحاسوب أو أي جهاز ذكي العمل أو الاستجابة للأوامر.

تكمن أهمية المعالج (CPU) في قدرته على معالجة البيانات بسرعة عالية، إذ تترجم كفاءته إلى أداء الجهاز ككل. ومع ذلك، فإن تزايد حجم العمليات الحسابية قد يؤدي أحيانًا إلى بطء في الاستجابة أو حتى إلى تعطل النظام في حال تجاوز الحمل قدرة المعالج.

اليوم تصنع أغلب المعالجات باستخدام تقنيات أشباه الموصلات على الدوائر المتكاملة، وتتوفر بتصميمات وأجيال متعددة. وتعتبر شركتا Intel و AMD من أبرز المنافسين في هذا المجال منذ أكثر من خمسة عقود. وفي هذا المقال عبر وسام ويب سنتعرف بعمق على وحدة المعالجة المركزية، آلية عمل المعالجات، وأهم العوامل التي تحدد كفاءتها.

جدول المحتويات

- ما هي المعالج (CPU) ؟

- خطوات تصنيع معالج الكمبيوتر من الرمل (الكوارتز) إلى المعالج النهائي (CPU)

- المكونات الأساسية للمعالج (CPU)

- أداء المعالج (CPU) ودورة الجلب والتنفيذ

- وحدات تشغيل المعالج (CPU)

- بنية وحدة المعالجة المركزية (CPU Architecture)

- الفرق بين RISC أوCISC أو ARM مقابل x86

- الفرق بين المعالج (CPU) لـ 32 بت و64 بت (x86 مقابل x64)

- الاختلافات في بنية ARM وX86-64

- مؤشرات أداء المعالج (CPU)

- الفرق بين المعالجة أحادية النواة ومتعددة النواة في المعالج (CPU)

- ما هي الخيوط في وحدة المعالجة المركزية (CPU Threads)؟

- ما هو Hyper-Threading أو SMT في المعالج (CPU)؟

- دور المعالج (CPU) في الألعاب

- ما هو عنق الزجاجة Bottleneck في المعالج (CPU)؟

- ما هي معاني الحروف (لمعالجات Intel و AMD)؟

- في الختام

ما هي المعالج (CPU)؟

المعالج (CPU) أو وحدة المعالجة المركزية (بالإنجليزية: Central Processing Unit) بأنه المكون الأساسي في أجهزة الكمبيوتر والأجهزة الإلكترونية الحديثة، والمسؤول عن تنفيذ التعليمات وإجراء العمليات الحسابية والمنطقية. ويُطلق عليه غالبًا “عقل النظام” نظرًا لدوره الجوهري في تشغيل البرامج وأداء مختلف المهام.

تم تصميم المعالج ليعمل كشريحة دائرة متكاملة رئيسية (IC) قادرة على التعامل مع أنواع متعددة من البيانات والتعليمات، مثل الحسابات الرياضية، العمليات المنطقية، تخزين البيانات واسترجاعها، إضافة إلى التحكم في تدفق الأوامر. وتتم هذه العمليات عبر دورة عمل محددة تبدأ بجلب التعليمات من الذاكرة، ثم فك ترميزها، وأخيرًا تنفيذها بدقة وسرعة عالية.

تقاس سرعة المعالج، أو ما يعرف بسرعة الساعة (Clock Speed)، بوحدة الهرتز (Hz)، أي بعدد الدورات التي يُجريها في الثانية الواحدة. وتُستخدم وحدات أكبر مثل الكيلوهرتز (KHz)، الميجاهرتز (MHz)، والجيجاهرتز (GHz) لقياس سرعة المعالجات الحديثة، حيث تشير السرعة الأعلى إلى قدرة أكبر على تنفيذ العمليات في وقت أقصر.

ومع التطور التكنولوجي، أصبحت المعالجات أكثر سرعة وكفاءة، مما مكن أجهزة الكمبيوتر والهواتف الذكية والخوادم من تشغيل تطبيقات معقدة وإنجاز المهام بشكل أسرع. ولهذا تُعتبر المعالجات مكونًا أساسيًا في مختلف الأجهزة بدءًا من الحواسيب الشخصية والهواتف المحمولة، وصولًا إلى مراكز البيانات المتقدمة.

ورغم أن مصطلحي المعالج و وحدة المعالجة المركزية يستخدمان بشكل متبادل، إلا أن الـ CPU ليس المعالج الوحيد داخل الكمبيوتر. فهناك على سبيل المثال معالج الرسوميات (GPU) المسؤول عن معالجة الرسومات والألعاب، إضافة إلى وحدات أخرى داخل الجهاز تقوم بمهام معالجة متخصصة. ومع ذلك، يبقى مصطلح “المعالج” شائع الاستخدام للإشارة تحديدًا إلى وحدة المعالجة المركزية.

في سوق المعالجات، تعد شركتا Intel و AMD أبرز اللاعبين الرئيسيين، حيث تتنافسان منذ عقود على تطوير أسرع وأكثر كفاءة من وحدات المعالجة المركزية لتلبية احتياجات المستخدمين والأجهزة بمختلف فئاتها.

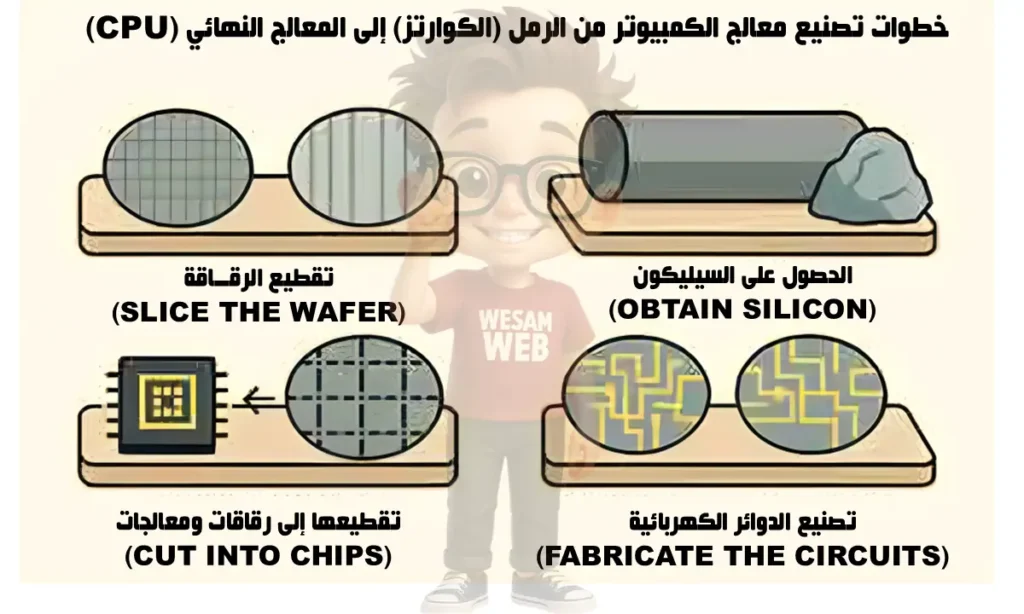

خطوات تصنيع معالج الكمبيوتر من الرمل (الكوارتز) إلى المعالج النهائي (CPU)

بناءً على عملية التصنيع القياسية المستخلصة من مصادر موثوقة حول تحويل الرمل إلى معالج، إليك الخطوات الرئيسية بشكل مبسط ومنظم:

1. استخراج وتنقية السيليكون من الرمل (تواجد مادة السيليكون)

يبدأ التصنيع من الرمل الذي يحتوي على الكوارتز (SiO2)، وهو المصدر الطبيعي للسيليكون. يتم تسخين الرمل في أفران عالية الحرارة مع الكربون لفصل السيليكون عن الأكسجين، مما ينتج سيليكون خام بنقاوة 98-99%. ثم يخضع لعمليات تنقية متقدمة مثل التقطير أو التحليل الكهروكيميائي للوصول إلى نقاوة تصل إلى 99.9999%، حيث يُعتبر السيليكون المادة الأساسية في صناعة أشباه الموصلات لضمان عدم وجود شوائب تؤثر على التوصيل الكهربائي.

2. تشكيل قضبان السيليكون وإنتاج الرقائق (مرحلة الإنتاج)

بعد التنقية، يذاب السيليكون السائل في فرن ويستخدم بذرة بلورية صغيرة لسحب بلورة أحادية الاتجاه ببطء (طريقة تشوزالسكي CZ أو طريقة المنطقة العائمة FZ). تستغرق هذه العملية ساعات لتشكيل قضيب طوله يصل إلى متر ونقي في الوسط. يقطع القضيب إلى شرائح رقيقة (وايفرز) بسمك 0.5-1 مم باستخدام منشار ماسي، ثم يلمع سطحها ليكون أملسًا جدًا (أقل من نانومتر) لاستقبال الطبقات اللاحقة. هذه الرقائق هي الأساس لصنع آلاف المعالجات من رقاقة واحدة.

3. عزل وتحديد خصائص الموصل (مرحلة تحديد خصائص الموصل)

يغطى سطح الرقاقة بطبقة رقيقة من ثاني أكسيد السيليكون (SiO2) عبر عملية أكسدة حرارية، لتحديد المناطق التي تسمح بمرور التيار الكهربائي (موصل) أو تمنعه (عازل). هذا ينشئ “الترانزستورات” الأساسية، حيث يضاف الدوبانت (شوائب مثل الفوسفور للنوع N أو البورون للنوع P) عبر الانتشار أو الزرع الأيوني لتعديل خصائص التوصيل، مما يسمح بتشكيل دوائر متكاملة صغيرة الحجم.

4. طباعة الدوائر بالضوء (مرحلة صنع القوالب وطباعتها)

تطبق طبقة من مادة حساسة للضوء (Photoresist) على الرقاقة، ثم يستخدم قناع ضوئي (Photomask) لتعريض أجزاء محددة للضوء فوق البنفسجي في عملية التصوير الضوئي (Photolithography). يزال الجزء المعرض للضوء، ويُحفر السطح بالكيماويات لإنشاء أخاديد دقيقة (تصل إلى نانومترات).

تكرر هذه الخطوة عشرات المرات (أكثر من 500 خطوة) لإضافة طبقات متعددة من المعادن والعوازل، باستخدام تقنيات مثل حزمة الإلكترونات أو الأشعة السينية للدقة العالية، مما يبني الترانزستورات والأسلاك داخل المعالج.

5. الاختبار، القطع، والتعبئة (مرحلة التشويب والإنهاء)

يضاف المزيد من الشوائب لإكمال الترانزستورات، ثم تُختبر الرقاقة ككل للكشف عن العيوب. يُقطع الوايفر إلى رقائق فردية باستخدام ليزر، وتختبر كل رقاقة للتأكد من أدائها. الرقائق الناجحة تغلف في حزمة واقية مع أطراف اتصال (pins)، وتضاف طبقة حماية، لتصبح معالجًا جاهزًا للاستخدام. العملية بأكملها تستغرق 2-3 أشهر، وتنتج ملايين الترانزستورات في مساحة صغيرة (مثل مليارات في معالج حديث).

المكونات الأساسية للمعالج (CPU)

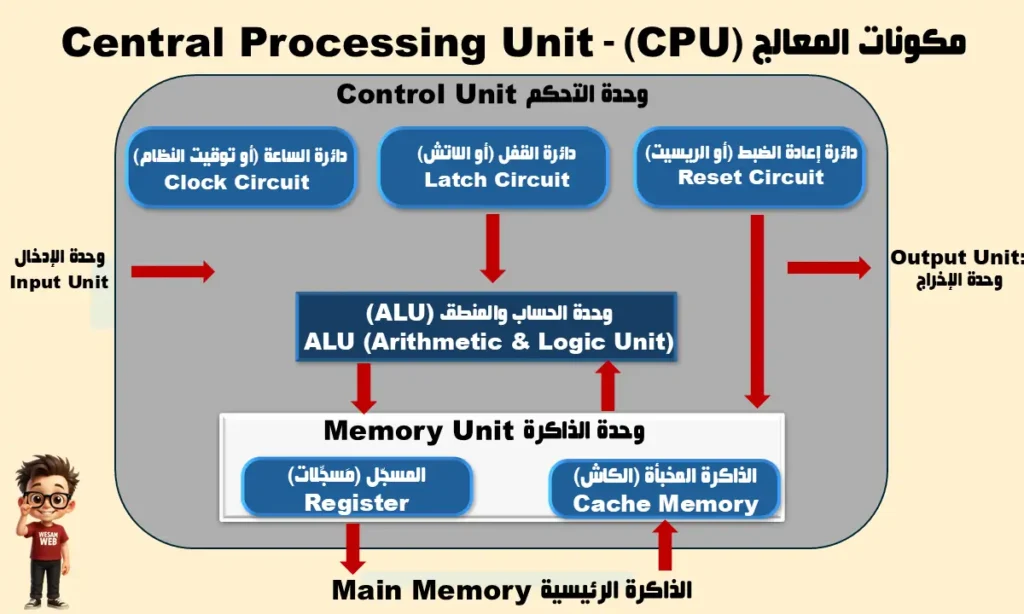

يتكون المعالج (CPU) من عدة وحدات أساسية تعمل بتناغم كامل لضمان تنفيذ التعليمات ومعالجة البيانات بكفاءة عالية. وتشمل هذه الوحدات:

1. وحدة التحكم (Control Unit – CU)

وهي المسؤولة عن إدارة المعالج عبر إرسال إشارات تنظيمية إلى باقي المكونات مثل Clock و Reset و Latch. وتشمل:

- دائرة الساعة (Clock Circuit): تعمل كمنظم لسرعة المعالج عبر تحديد عدد النبضات في الثانية، ما يحدد عدد العمليات التي يمكن للمعالج إنجازها.

- دائرة القفل (Latch Circuit): مسؤولة عن تثبيت البيانات مؤقتًا داخل المعالج حتى تُستخدم في الخطوة التالية.

- دائرة إعادة الضبط (Reset Circuit): تعيد المعالج إلى وضعه الابتدائي عند تشغيل الجهاز أو حدوث خلل.

2. وحدة الحساب والمنطق (Arithmetic & Logic Unit – ALU)

تعتبر ALU المسؤولة عن تنفيذ جميع العمليات الحسابية (الجمع، الطرح، الضرب، القسمة) والعمليات المنطقية (AND، OR، NOT، المقارنات). وهي المحرك الأساسي لعمليات المعالجة داخل الـ CPU.

3. وحدة الذاكرة (Memory Unit)

وظيفتها تخزين البيانات والتعليمات مؤقتًا أثناء التنفيذ، وتشمل:

- المسجل (Register): ذاكرة صغيرة جدًا داخل المعالج تُستخدم لتخزين البيانات والأوامر بشكل لحظي وسريع.

- الذاكرة المخبأة (Cache Memory): ذاكرة سريعة قريبة من وحدة المعالجة تُستخدم لتخزين البيانات الأكثر استخدامًا لتقليل زمن الوصول وتسريع الأداء.

4. وحدة الإدخال والإخراج (Input & Output Units)

- وحدة الإدخال (Input Unit): تستقبل البيانات من أجهزة الإدخال مثل لوحة المفاتيح والفأرة وتحوّلها إلى إشارات يمكن للمعالج التعامل معها.

- وحدة الإخراج (Output Unit): ترسل نتائج المعالجة إلى أجهزة الإخراج مثل الشاشة أو الطابعة.

5. الذاكرة الرئيسية (Main Memory)

وهي الذاكرة الأساسية للنظام، مثل RAM، حيث يتم تخزين البيانات والتعليمات قيد التنفيذ قبل أن يتم التعامل معها داخل الـ CPU.

بهذه المكوّنات يعمل المعالج (CPU) كنظام متكامل يجمع بين إدارة العمليات (وحدة التحكم)، تنفيذ العمليات (ALU)، تخزين البيانات (Registers و Cache و RAM)، والتفاعل مع المستخدم (وحدات الإدخال والإخراج).

أداء المعالج (CPU) ودورة الجلب والتنفيذ

يعمل المعالج (CPU) وفق دورة أساسية تُعرف باسم دورة الجلب والتنفيذ، وتتكون من أربع خطوات رئيسية متتابعة تتكرر ملايين المرات في الثانية الواحدة:

- 1. جلب التعليمات (Fetch)

- في البداية، يقوم المعالج بجلب التعليمات من الذاكرة (عادةً من ذاكرة الوصول العشوائي – RAM). ويُستخدم في هذه المرحلة عداد البرنامج (Program Counter – PC) لتحديد عنوان التعليمة التالية وضمان تنفيذ الأوامر بالترتيب الصحيح.

- 2. فك التشفير أو الترجمة (Decode)

- بعد جلب التعليمة، يتم فك تشفيرها وتحويلها إلى صيغة يفهمها المعالج (لغة الآلة أو الثنائية). في هذه المرحلة، يتم تفسير الأوامر القادمة من لغات البرمجة عالية المستوى بعد أن تكون قد ترجمت سابقًا إلى رموز قابلة للتنفيذ (Machine Code).

- 3. التنفيذ (Execute)

- في هذه الخطوة، يقوم المعالج بتنفيذ التعليمة. فإذا كانت العملية حسابية أو منطقية، يتم معالجتها بواسطة وحدة الحساب والمنطق (ALU). أما إذا كانت عملية تحكم أو نقل بيانات، فتتم إدارتها عبر وحدة التحكم (CU) أو وحدات أخرى داخل المعالج.

- 4. التخزين (Store)

- بعد التنفيذ، يتم تخزين النتيجة في أحد السجلات (Registers) أو في الذاكرة (RAM)، ليعاد استخدامها لاحقًا في أوامر أخرى، أو لإخراجها عبر أجهزة الإخراج (مثل الشاشة أو الطابعة).

هذه الدورة – Fetch, Decode, Execute, Store – تمثل قلب عمل المعالج. وبمجرد الانتهاء من تنفيذ تعليمة واحدة، ينتقل المعالج فورًا إلى التعليمة التالية ويكرر الدورة بسرعة هائلة، مما يسمح للجهاز بأداء ملايين أو حتى مليارات العمليات في الثانية الواحدة.

وحدات تشغيل المعالج (CPU)

يتكون كل معالج من ثلاثة مكونات تشغيلية تعمل معًا لمعالجة التعليمات:

- وحدة الحساب والمنطق (ALU): وحدة ALU هي وحدة دائرة رقمية متطورة تقوم بوظائف الحساب والمقارنة. يتم فصل وحدة الحساب والحساب (ALU) في بعض المعالجات إلى قسمين: AU (للعمليات الحسابية) وLU (للعمليات المنطقية).

- وحدة التحكم في الذاكرة (CU أو عداد البرنامج): هذه هي وحدة الدائرة التي توجه وتنظم أنشطة وحدة المعالجة المركزية وتحدد كيفية الاستجابة للتعليمات الصادرة إلى وحدة الحساب والمنطق، بالإضافة إلى أجهزة الإدخال والإخراج. قد تعمل وحدة التحكم لكل معالج بشكل مختلف بناءً على بنيته المعمارية.

- وحدة التسجيل (Register): هي وحدة معالجة مسؤولة عن التخزين المؤقت للبيانات المعالجة والتعليمات والعناوين وتسلسلات البت والمخرجات ويجب أن تتمتع بالقدرة الكافية للقيام بذلك. تحتوي المعالجات ذات بنية 64 بت على سجلات 64 بت، بينما تحتوي المعالجات ذات بنية 32 بت على سجلات 32 بت.

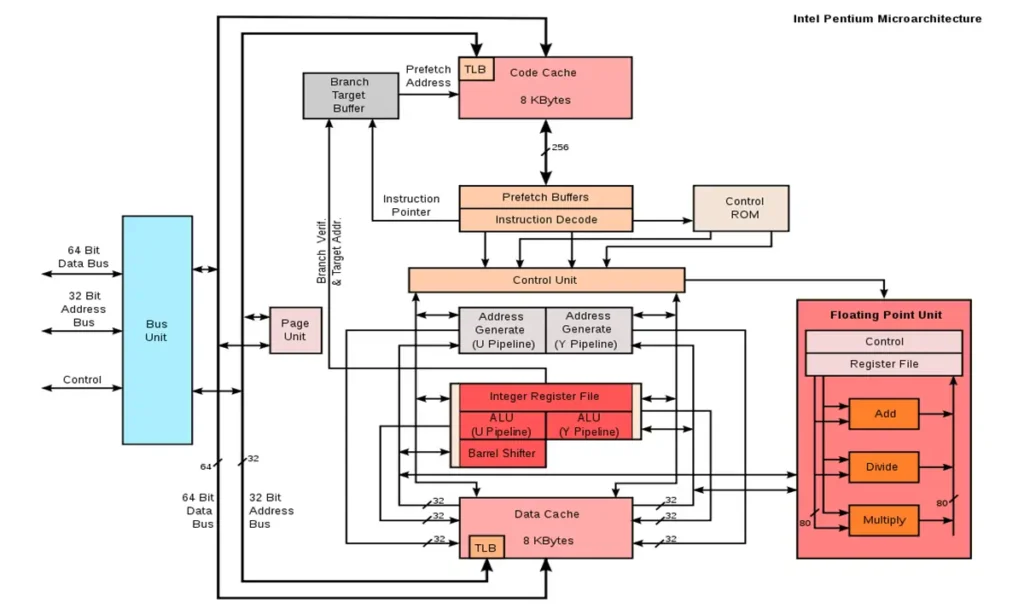

بنية وحدة المعالجة المركزية (CPU Architecture)

تشير بنية المعالج إلى التصميم الداخلي لوحدة المعالجة المركزية وكيفية تنظيمها لأداء المهام مثل تنفيذ التعليمات، العمليات الحسابية، وإدارة تدفق البيانات.

ما هي مجموعة التعليمات (Instruction Set)؟

مجموعة التعليمات هي الأوامر الأساسية التي يستطيع المعالج تنفيذها مباشرة. تترجم برامج الحاسوب المكتوبة عدة لغات البرمجة عالية المستوى إلى هذه التعليمات بلغة الآلة (الثنائية: 0 و1) التي يفهمها المعالج.

الفئات الرئيسية لمجموعة التعليمات:

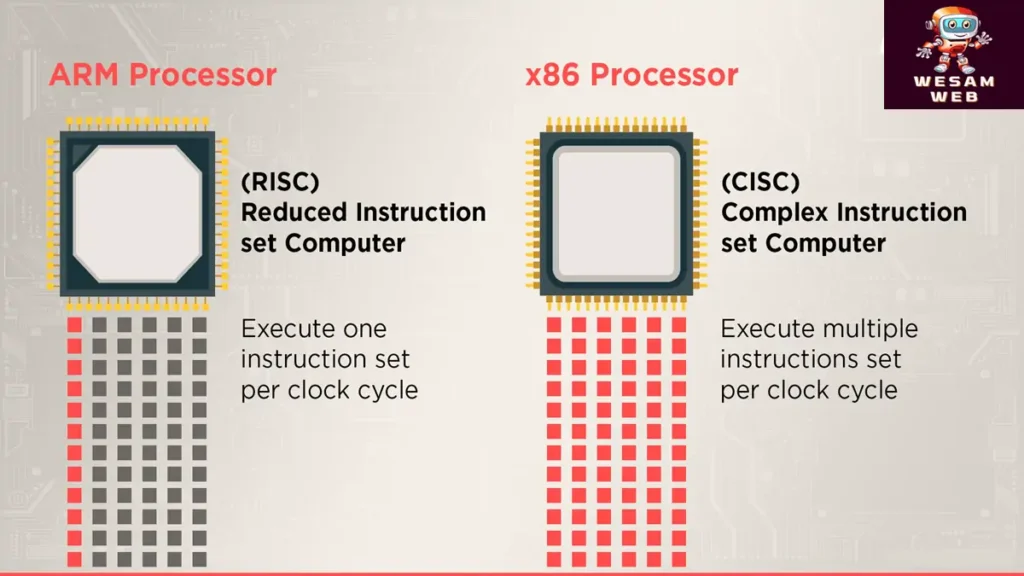

- المعالجات ذات مجموعة التعليمات المخفضة (RISC):

- تعتمد على تعليمات بسيطة تُنفذ عادة في دورة ساعة واحدة.

- تصميمها أقل تعقيدًا وأرخص تكلفة.

- فعّالة في السرعة وتبسيط توجيه البيانات.

- مثال: معالجات ARM المستخدمة في الهواتف الذكية.

- المعالجات ذات مجموعة التعليمات المعقدة (CISC):

- تحتوي على تعليمات أكثر تعقيدًا، يمكنها تنفيذ عدة عمليات في أمر واحد.

- تحتاج غالبًا إلى عدة دورات ساعة لتنفيذ التعليمات.

- أكثر شيوعًا في الحواسيب المكتبية والخوادم (مثل معالجات Intel و AMD).

ملاحظة مهمة:

رغم الاختلاف بين RISC و CISC، إلا أن التطويرات الحديثة جعلت الحدود بينهما أقل وضوحًا؛ فمعالجات x86 (CISC) تتبنى الكثير من تقنيات RISC لتحسين الأداء، بينما معالجات RISC أصبحت أكثر تعقيدًا مع مرور الوقت.

الفرق بين RISC أوCISC أو ARM مقابل x86

في فئة مجموعة التعليمات، تعد RISC وCISC نقطتي البداية والنهاية لهذا الطيف، كما تظهر أيضًا عدة مجموعات إضافية. أولاً، دعنا نتعرف على الفروق الأساسية بين RISC وCISC:

| RICS أو مدونة الممارسات المخفضة | CISC أو مجموعة التعليمات المعقدة |

|---|---|

| تعتبر مجموعات تعليمات RISC أساسية؛ فهي تؤدي إجراءً واحدًا فقط ويمكن معالجتها في دورة واحدة بواسطة المعالج. | على الرغم من أن تعليمات CISC تنفذ العديد من الإجراءات، إلا أنا لا يمكن معالجتها في دورة واحدة بواسطة وحدة المعالجة المركزية. |

| يعد توجيه المعلومات في المعالجات المستندة إلى RISC أكثر كفاءة وبساطة؛ يعد تصميم هذه التوجيهات أساسيًا جدًا بحيث يمكن تنفيذها على أجزاء. | تعد معالجات CISC أكثر تعقيدًا، كما أن تنفيذ التعليمات أكثر صعوبة. |

| لتنفيذ التعليمات، تتطلب أجهزة الكمبيوتر المستندة إلى RISC البيانات المخزنة. | ليست هناك حاجة لتحميل العمليات بشكل فردي في المعالجات المستندة إلى CISC لأنك قد تتعامل مع التعليمات مباشرة من خلال ذاكرة الوصول العشوائي (RAM). |

| يتم تنفيذ جميع العمليات بواسطة برنامج RISC، والذي لا يتطلب أجهزة معقدة. | متطلبات الأجهزة لتصميم CISC أكبر. يتم تنفيذ تعليمات CISC في الأجهزة، وغالبًا ما يكون البرنامج أبسط من RISC. ولهذا السبب تتطلب الأنظمة المستندة إلى CISC تعليمات برمجية أقل، وتؤدي التعليمات جزءًا كبيرًا من العملية. |

وكما ذكرنا سابقًا، يتم استخدام مزيج من هاتين المجموعتين (CISC أو RISC) في تصميم CPU المعاصرة اليوم. تعتمد بنية AMD x86، على سبيل المثال، على مجموعة تعليمات CISC ولكنها تتضمن رمزًا صغيرًا لتبسيط العمليات الصعبة المشابهة لـ RISC.

الآن بعد أن حددنا الفروق بين النوعين الرئيسيين لمجموعات التعليمات، سننظر في كيفية استخدامها في بنية المعالج.

عند اختيار هاتف أو جهاز لوحي، انتبه إلى بنية المعالج. تستخدم بعض الطرز معالجات Intel، بينما يعتمد البعض الآخر على بنية ARM.

افترض أن كل معالج لديه مجموعة تعليمات فريدة يجب إنشاؤها بشكل مستقل حتى يتمكن كل معالج من تشغيل برامج مختلفة. على سبيل المثال، لكل CPU AMD، كان هناك حاجة إلى إصدار Windows فريد، أو تم إنتاج الآلاف من إصدارات Photoshop لمعالجات مختلفة.

ونتيجة لذلك، تم إنشاء بنيات قياسية تعتمد على فئات RISC أو CISC، أو مزيج من الاثنين، وتم الإعلان عن مواصفات هذه المعايير. تتضمن معايير الهندسة المعمارية هذه ARM وPowerPC وx86-64 وIA-64، وسنناقش اثنين من أبرزها والاختلافات بينهما أدناه:

الفرق بين المعالج (CPU) لـ 32 بت و64 بت (x86 مقابل x64)

الفرق الرئيسي بين المعالج 32 بت والمعالج 64 بت، المعروفين أحيانًا بـ x86 و x64 (أو x86-64)، هو عدد البتات المستخدمة لتمثيل البيانات وعناوين الذاكرة. فيما يلي أهم الفروق بينهما:

| العنصر | معالج 32 بت (x86) | معالج 64 بت (x64 أو x86-64) |

|---|---|---|

| حجم البيانات وعناوين الذاكرة | يدعم حتى 4 جيجابايت من RAM (232 عنوان ذاكرة). | يدعم نظريًا حتى 18.4 مليون تيرابايت من RAM (264 عنوان ذاكرة)، والأنظمة تدعم مئات الجيجابايت. |

| الأداء | مناسب للتطبيقات الأساسية والاستخدام العادي. | أداء محسن للتطبيقات الكبيرة والمعقدة ومعالجة البيانات الضخمة. |

| توافق البرامج | يشغل فقط تطبيقات 32 بت. | يشغل تطبيقات 32 بت و64 بت (مع توافق عكسي). |

| دعم أنظمة التشغيل | يدعم أنظمة تشغيل 32 بت فقط. | يدعم أنظمة تشغيل 64 بت (ولا يشغل 32 بت إلا عبر المحاكاة). |

| الأمان | ميزات أمان محدودة. | ميزات أمان متقدمة مثل DEP و ASLR. |

| توافر البرامج | البرامج 32 بت في تراجع مستمر. | البرامج 64 بت أصبحت المعيار الأساسي الآن. |

- إذا كان جهازك قديمًا بذاكرة RAM أقل من 4 غيغابايت، فالأرجح أنه يعمل بمعالج 32 بت.

- أما الأجهزة الحديثة بجميع أنواعها تقريبًا فهي مزودة بمعالجات 64 بت لأنها أسرع، أكثر أمانًا، وتدعم ذاكرة هائلة مقارنة بالـ 32 بت.

الفرق الرئيسي بين المعالجات 32 بت و64 بت يكمن في قدرتهم على تمثيل البيانات وعناوين الذاكرة. يمكن للمعالجات 64 بت التعامل مع مساحات ذاكرة أكبر وربما تقدم أداءً محسنًا لمهام معينة، مما يجعلها أكثر مناسبة لاحتياجات الحوسبة الحديثة. ومع ذلك، يعد التوافق بين نوع المعالج والبرنامج أو نظام التشغيل المستخدم أحد الاعتبارات المهمة عند اختيار بنية المعالج.

الاختلافات في بنية ARM وX86-64

ARM وx86-64 هما معماريتان متميزتان للمعالجات، ولكل منهما مجموعة خاصة به من الخصائص ومبادئ التصميم. فيما يلي بعض الاختلافات الرئيسية بين بنيات ARM وx86-64:

| معمارية | ARM | X86-64 |

|---|---|---|

| الفرق بين CISC و RISC | نظرًا لأن بنية ARM هي بنية وحدة المعالجة المركزية، فلا يوجد مصنع واحد. تم العثور على هذه التقنية في وحدات المعالجة المركزية Android و iPhone. | أنشأت شركة Intel بنية X86، والتي يتم استخدامها فقط في وحدات المعالجة المركزية (CPU) الخاصة بسطح المكتب والكمبيوتر المحمول الخاصة بالشركة. |

| تعقيد التعليمات | نظرًا لأن بنية ARM تستخدم دورة واحدة فقط لتنفيذ التعليمات، فإن المعالجات المستندة إلى هذه البنية تكون أكثر ملاءمة للأجهزة التي تتطلب معالجة أبسط. | تستخدم بنية Intel (أو بنية X86 المرتبطة ببرامج Windows 32 بت) بشكل متكرر حوسبة CISC، مما يؤدي إلى مجموعة تعليمات أكثر تعقيدًا إلى حد ما ووقت تنفيذ أطول. |

| مقارنة بين وحدات المعالجة المركزية المحمولة و لسطح المكتب | بسبب اعتماد بنية ARM على البرمجيات، يتم استخدامها بشكل متزايد في تصميم معالجات الهاتف؛ يعمل ARM (بشكل عام) بشكل أفضل مع التقنيات الأصغر حجمًا التي لا تتمتع بإمكانية الوصول المستمر إلى مصدر الطاقة. | نظرًا لأن بنية Intel X86 تعتمد بشكل أكبر على الأجهزة، فغالبًا ما يتم استخدامها لإنشاء معالجات للأجهزة الأكبر حجمًا مثل أجهزة الكمبيوتر المكتبية؛ تركز Intel على الأداء وتعتبر بنية متفوقة لمجموعة واسعة من التقنيات. |

| استهلاك الطاقة | نظرًا لمجموعة الحوسبة أحادية الدورة، فإن بنية ARM لا تستهلك طاقة أقل فحسب، بل تتمتع أيضًا بدرجة حرارة تشغيل أقل من بنية Intel X86؛ تعتبر بنيات ARM مثالية لتصميم معالجات الهاتف لأنها تقلل من كمية الطاقة المطلوبة للحفاظ على تشغيل النظام وتنفيذ أوامر المستخدم. | إن تصميم Intel موجه نحو الأداء، لذا يجب أن يكون مستخدمو أجهزة سطح المكتب أو الكمبيوتر المحمول الذين لديهم إمكانية الوصول إلى مصدر طاقة غير محدود على ما يرام. |

| سرعة المعالج | غالبًا ما تكون وحدات المعالجة المركزية المستندة إلى ARM أبطأ من نظيراتها المستندة إلى Intel لأنها تجري عمليات حسابية بطاقة أقل لتحقيق الاستخدام الأمثل. | لإجراء عمليات حسابية أسرع، يتم استخدام المعالجات المستندة إلى بنية Intel X86. |

| نظام التشغيل | يمكن الوصول إلى بنية ARM للاستخدام على أجهزة Android، وهي البنية الأكثر شيوعًا في كل سوق حيث يوجد حساب بالفعل. يعتمد هذا النظام على هذا السيناريو الذي يتم فيه إهدار الوقت والطاقة، مع إمكانية إفراغ عمر البطارية والتعافي تمامًا من الصدمة. | تُستخدم معمارية إنتل، التي تحمل اللقب المعماري غالب حكماني ميكاند، في الكمبيوتر اللوحي ونظام التشغيل ويندوز. بالطبع، تتوفر الآن خدمة Microsoft Service Pro Ax كبديل لبنية ARM، بالإضافة إلى الإصدار الكامل من Windows، اعتبارًا من عام 2019. انتظر حتى تحصل على نسخة كاملة من Windows قبل إرسال بريد إلكتروني إلى بنية Intel إذا كان لديك لاعب أو جهاز لوحي على جهاز الكمبيوتر الخاص بك. |

تم تصميم معماريات ARM وx86-64 لحالات استخدام مختلفة ولها نقاط قوة ونقاط ضعف خاصة بها. تتفوق معالجات ARM في كفاءة استهلاك الطاقة وتوجد بشكل شائع في الأجهزة المحمولة والمدمجة، بينما تشتهر معالجات x86-64 بتوافقها وأدائها، مما يجعلها خيارًا شائعًا لأجهزة الكمبيوتر الشخصية والخوادم.

يعتمد الاختيار بين هذه البنى على المتطلبات المحددة للجهاز أو النظام الذي يتم تصميمه.

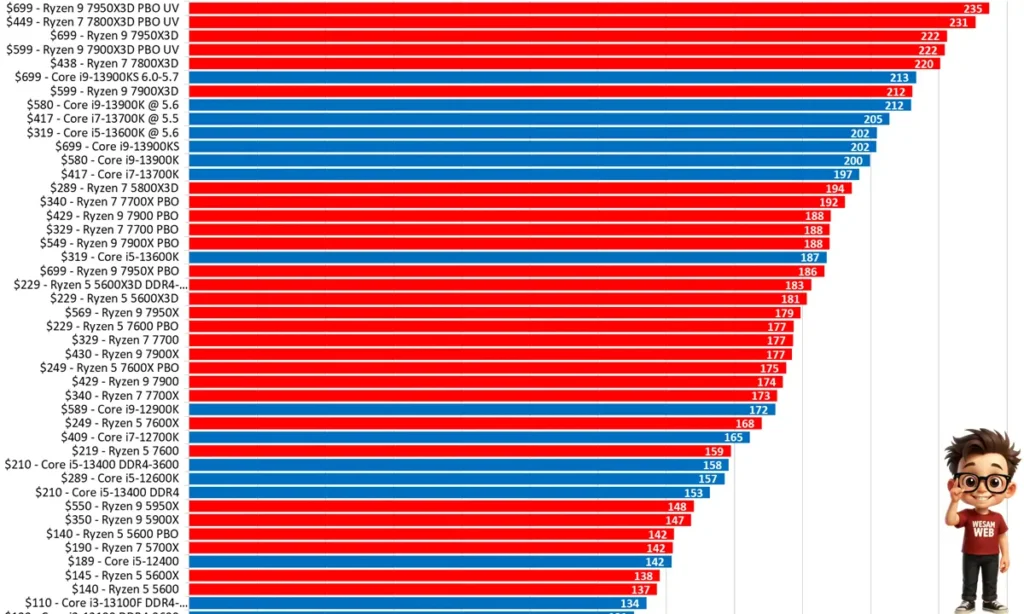

مؤشرات أداء المعالج (CPU)

أداء المعالج له تأثير كبير على سرعة تحميل البرامج وسلاسة تنفيذها، وهناك عدة معايير لقياس أداء كل معالج، أحدها هو التردد (سرعة الساعة).

لذلك، في حين يمكن اعتبار تردد كل نواة معيارًا لقياس قوة المعالجة الخاصة بها، إلا أن هذا المعيار لا يمثل بالضرورة الأداء العام للمعالج، والعديد من العوامل الأخرى مثل عدد النوى والخيوط، والبنية الداخلية (التآزر بين النوى)، وسعة ذاكرة التخزين المؤقت، وإمكانية رفع تردد التشغيل، والطاقة الحرارية، واستهلاك الطاقة، وIPC، وما إلى ذلك، تم أخذها أيضًا في الاعتبار للحكم على الأداء العام للمعالج.

التآزر هو التأثير الناتج عن تدفق أو تفاعل عنصرين أو أكثر. إذا كان هذا التأثير أكبر من مجموع التأثيرات التي يمكن أن ينتجها كل عنصر من هذه العناصر الفردية، فهذا يعني أن التآزر قد حدث.

وفيما يلي سنوضح المزيد عن العوامل المؤثرة على أداء المعالج:

تردد المعالج

تردد المعالج (CPU Frequency)، أو ما يعرف بسرعة الساعة (Clock Speed)، هو المقياس الذي يحدد عدد النبضات الكهربائية التي تولدها الساعة الداخلية للمعالج في الثانية الواحدة. يُقاس هذا التردد بالهرتز (Hz)، وعادة بالجيجاهرتز (GHz) أي مليار نبضة في الثانية.

كلما ارتفع تردد الساعة، تمكن المعالج من تنفيذ التعليمات بشكل أسرع، مما يعزز من أدائه في معالجة البيانات. ومع ذلك، فإن سرعة الساعة ليست العامل الوحيد المؤثر في الأداء؛ فهناك عناصر أخرى مهمة مثل عدد الأنوية (Cores)، حجم الذاكرة المخبئية (Cache)، وكفاءة تصميم المعمارية الداخلية.

في الوقت الحالي، لم تعد الشركات المصنعة تركز فقط على رفع التردد بسبب قيود الطاقة والحرارة، بل اتجهت إلى تطوير معالجات متعددة النوى وتحسين البنية الداخلية لتوفير أداء أعلى مع كفاءة أفضل في استهلاك الطاقة.

عند اختيار معالج جديد، يجب النظر إلى المواصفات الكاملة وليس إلى سرعة الساعة فقط، لضمان توافقه مع احتياجاتك سواء للألعاب، التصميم، أو الاستخدام المكتبي.

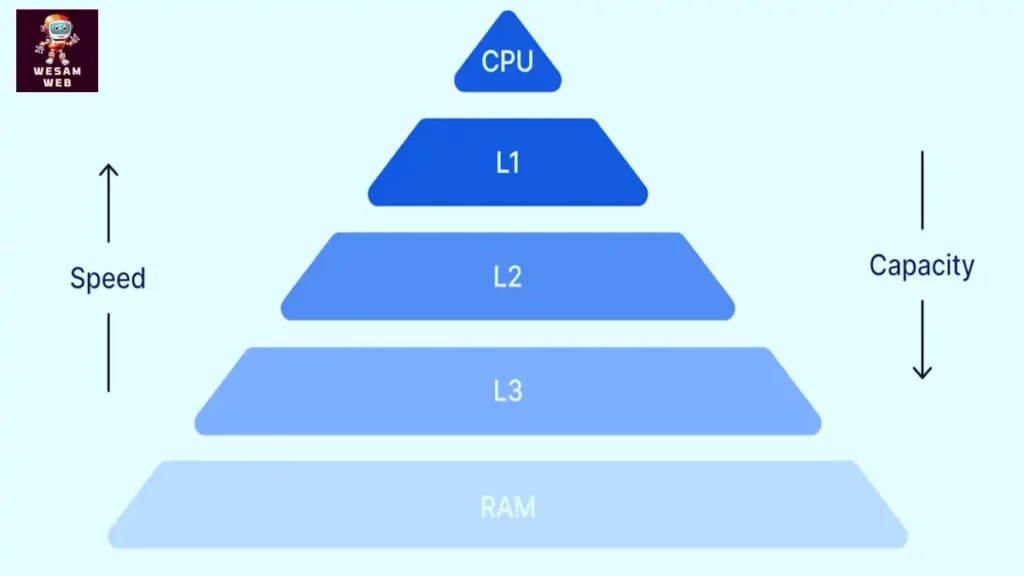

الذاكرة المؤقتة (Cache Memory)

تعد الذاكرة المؤقتة (Cache) أحد العوامل الأساسية التي تحدد أداء المعالج (CPU)، إذ تعمل كوسيط سريع بين المعالج (CPU) وذاكرة الوصول العشوائي (RAM). بفضل قربها من المعالج وسرعتها العالية، تقوم هذه الذاكرة بتخزين البيانات والتعليمات الأكثر استخدامًا بشكل مؤقت، مما يقلل زمن الوصول ويسرّع تنفيذ الأوامر.

تنقسم الذاكرة المؤقتة عادة إلى عدة مستويات:

- المستوى الأول (L1):

الأقرب إلى المعالج (CPU) والأسرع بين المستويات، لكنه الأصغر حجمًا. يستخدم لتخزين البيانات الأكثر أهمية التي يحتاجها المعالج بشكل فوري. - المستوى الثاني (L2):

أكبر حجمًا من L1 لكنه أبطأ نسبيًا. في المعالجات الحديثة أصبح مدمجًا داخل الشريحة نفسها لتقليل التأخير، بعد أن كان في السابق موضوعًا على اللوحة الأم. - المستوى الثالث (L3):

ذاكرة مشتركة بين جميع أنوية المعالج، توفر سعة أكبر من L1 وL2 لكنها أقل سرعة، وتُستخدم لتبادل البيانات بين الأنوية. - المستوى الرابع (L4):

نادر نسبيًا، ويوجد في بعض المعالجات عالية الأداء. يتميز بسعة كبيرة وسرعة أقل مقارنةً بالمستويات السابقة، وغالبًا ما يكون مشتركًا أيضًا.

بشكل عام، كلما زادت سعة الذاكرة المؤقتة ارتفع أداء المعالج، ولكن ذلك يؤدي أيضًا إلى ارتفاع سعره. وللتأكد من كفاءة المعالج (CPU)، يمكن للمستخدمين الاستعانة بأدوات قياس الأداء (Benchmarking) بدلاً من الاعتماد فقط على مواصفات الشركات المصنعة.

معالجة النوى

النواة هي وحدة معالجة المعالج التي يمكنها أداء أو معالجة جميع أنشطة الحوسبة بشكل مستقل. من هذا المنظور، يمكن اعتبار النواة بمثابة معالج صغير داخل المعالجات الأكبر.

يحتوي هذا القسم من المعالج على نفس الوحدات التشغيلية للحساب والعمليات المنطقية (ALU)، والتحكم في الذاكرة (CU)، والسجلات (Register) التي تجري عملية معالجة التعليمات من خلال دورة جلب وتنفيذ.

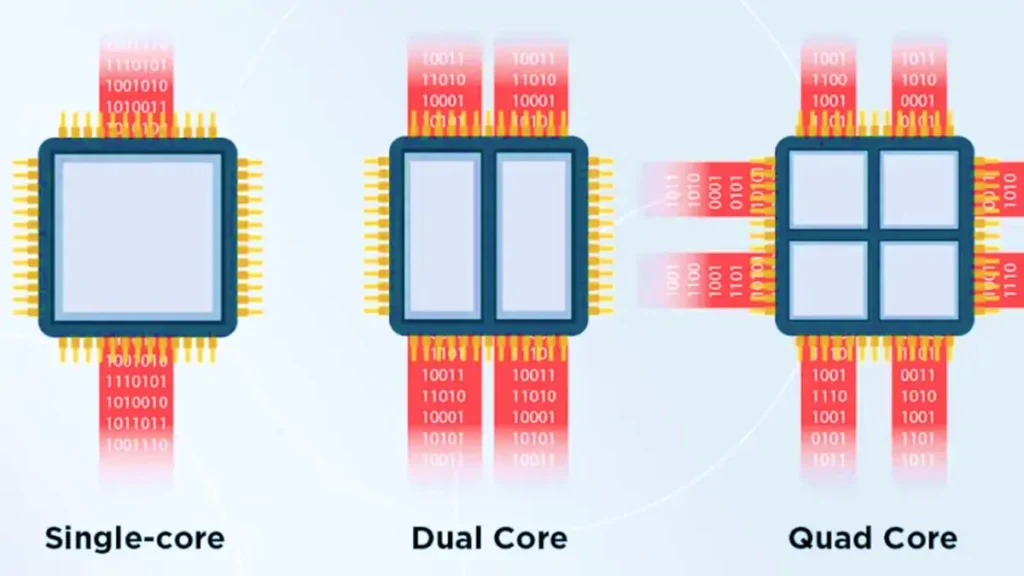

في الأصل، كانت المعالجات تحتوي على نواة واحدة فقط، ولكن معالجات اليوم عمومًا متعددة النواة، مع وجود نواتين أو أكثر على الأقل في دائرة متكاملة تعالج عمليتين أو أكثر في نفس الوقت. من المهم ملاحظة أن كل نواة يمكنها تنفيذ تعليمات واحدة فقط في كل مرة.

تستخدم المعالجات ذات النوى المتعددة المعالجة المتوازية (الحوسبة المتوازية) لتنفيذ مجموعات من التعليمات أو البرامج بشكل أسرع من ذي قبل. في الواقع، وجود المزيد من النوى لا يعني أن الأداء الإجمالي للمعالج سوف يتحسن. نظرًا لحقيقة أن العديد من التطبيقات لا تستخدم المعالجة المتوازية بعد.

أنواع النوى في المعالج (CPU)

1. المعالجات أحادية النواة (Single-core)

هي أقدم أنواع المعالجات، وتحتوي على نواة واحدة فقط قادرة على تنفيذ أمر واحد في كل مرة. هذا النوع غير فعّال في المهام المتعددة، حيث يجب إنهاء عملية قبل البدء في أخرى. ومع تشغيل أكثر من برنامج، ينخفض الأداء بشكل ملحوظ. كان قياس قوة هذه المعالجات يعتمد أساسًا على تردد الساعة (Clock Speed).

2. المعالجات ثنائية النواة (Dual-core)

تحتوي على نواتين داخل معالج واحد، مما يتيح تنفيذ عمليتين في الوقت نفسه بشكل أفضل من أحادية النواة. بفضل دعم تقنية تعدد الخيوط (Multithreading)، يمكنها التعامل مع أكثر من تدفق بيانات بكفاءة أعلى، ما يجعلها مناسبة للمهام المكتبية والبرامج البسيطة.

3. المعالجات رباعية النواة (Quad-core)

تضم أربع أنوية تعمل بشكل متوازي، وتوزّع عبء العمل بين النوى لتحسين الأداء في المهام المتعددة. تعتبر خيارًا مثاليًا للمستخدمين المحترفين واللاعبين الذين يحتاجون إلى قدرة معالجة أكبر من ثنائية النواة.

4. المعالجات سداسية النواة (Hexa-core)

تشمل ست أنوية، وتوفر سرعة أكبر وقدرة معالجة أعلى مقارنة بالمعالجات الرباعية. على سبيل المثال، اشتهرت بعض إصدارات Intel Core i7 وAMD Ryzen 5 بتوفير 6 أنوية مناسبة للألعاب والبرامج المتقدمة.

5. المعالجات ثمانية النواة (Octa-core)

مزودة بثمانية أنوية مستقلة، ما يمنحها أداءً قويًا في التطبيقات والألعاب الثقيلة. بعض التصميمات تعتمد على تقنية big.LITTLE التي تستخدم مزيجًا من أربع أنوية قوية للأداء وأربع أنوية موفرة للطاقة، مما يوازن بين القوة والكفاءة.

6. المعالجات العشرية النواة (Deca-core)

تضم عشرة أنوية، وتوفر قدرة هائلة على معالجة المهام المتعددة بشكل متزامن، ما يجعلها أكثر كفاءة من الأنواع السابقة. غالبًا ما تُستخدم في الحواسيب المتطورة وأجهزة السيرفر، وتوفر سرعة وأداء عاليين في المهام الثقيلة.

معلومة إضافية حديثة: لم يعد عدد الأنوية وحده المقياس الأساسي لقوة المعالج، فالمعماريات الحديثة (مثل Intel Alder Lake وAMD Ryzen 7000) تجمع بين أنوية عالية الأداء (Performance Cores) وأنوية عالية الكفاءة (Efficiency Cores)، ما يحقق توازنًا أفضل بين السرعة واستهلاك الطاقة.

الفرق بين المعالجة أحادية النواة ومتعددة النواة في المعالج (CPU)

1. المعالجة أحادية النواة (Single-core)

- تعتمد على نواة واحدة فقط لتنفيذ التعليمات.

- مناسبة للبرامج القديمة أو التطبيقات غير المهيأة للاستفادة من تعدد الأنوية.

- الأداء يقاس بشكل أساسي بتردد الساعة (Clock Speed).

2. المعالجة متعددة النوى (Multi-core)

- تتيح تنفيذ عدة مهام بالتوازي عبر أكثر من نواة.

- لا يعني العدد الأكبر من الأنوية دائمًا أداء أعلى، إلا إذا كان البرنامج أو النظام قادرًا على استغلالها.

- مثال توضيحي: سيارة سريعة (أحادي النواة) قد تكون أفضل لنقل شخصين، بينما الحافلة (متعدد النوى) أنسب لنقل مجموعة كبيرة في وقت واحد.

3. مفهوم النوى الهجينة (Hybrid Cores)

- ظهرت لمعالجة مشكلة استهلاك الطاقة المرتفع في المعالجات متعددة النوى التقليدية.

- تقوم على دمج نوعين من الأنوية:

- نوى P (Performance Cores): قوية، مخصصة للمهام الثقيلة مثل الألعاب والبرامج الضخمة.

- نوى E (Efficiency Cores): موفرة للطاقة، تدير مهام الخلفية والتطبيقات الخفيفة.

4. معالجات Intel Alder Lake (الجيل 12)

- أول من طبق مفهوم النوى الهجينة في معالجات x86.

- مثال:

- Core i9: يضم 8 نوى P + 8 نوى E.

- Core i7: يضم 8 نوى P + 4 نوى E.

- Core i5: يضم 6 نوى P + 4 نوى E.

- الميزة: أداء قوي عند الحاجة (النوى P) مع استهلاك طاقة منخفض عند المهام البسيطة (النوى E).

5. الفوائد العملية

- للاعبين والمستخدمين المحترفين: إمكانية تشغيل الألعاب الثقيلة بالتوازي مع مهام الخلفية دون التأثير على الأداء.

- للحواسيب المحمولة: عمر بطارية أطول وانخفاض الحرارة.

- للاستخدام اليومي: تشغيل التطبيقات الخفيفة على النوى E وتوفير النوى P للمهام الثقيلة.

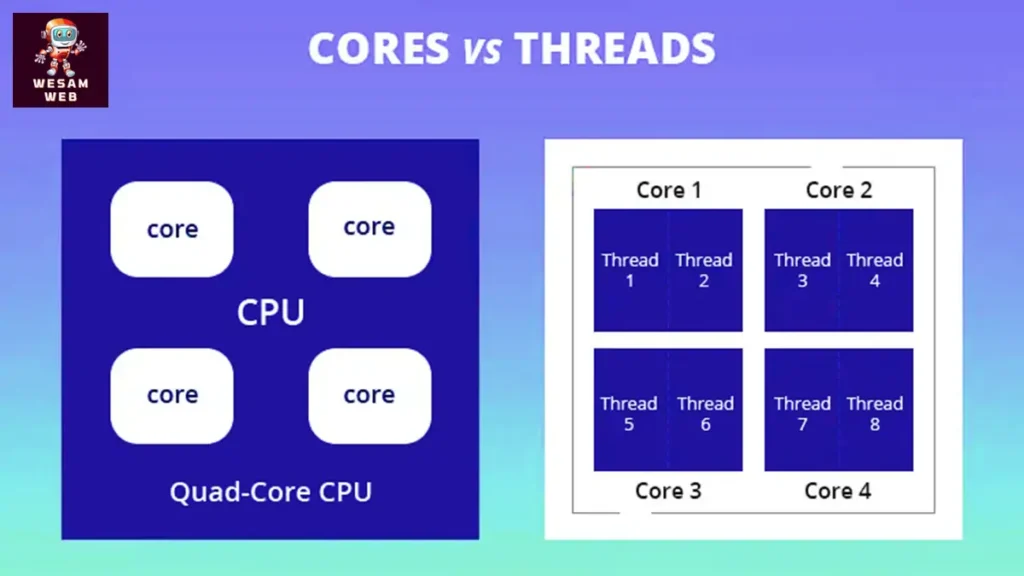

ما هي الخيوط في وحدة المعالجة المركزية (CPU Threads)؟

الخيط أو الـ Thread هو مسار معالجة افتراضي داخل وحدة المعالجة المركزية. يقوم المعالج بتنفيذ التعليمات عبر هذه الخيوط، بحيث يمكن لكل نواة مادية (Core) أن تدعم عادةً خيطين بفضل تقنية مثل Hyper-Threading من Intel أو SMT من AMD. هذا يعني أن المعالج رباعي الأنوية قد يتعامل مع ثمانية خيوط معالجة في وقت واحد.

كيف تعمل الخيوط؟

الخيوط ليست مكونات مادية داخل المعالج، وإنما تمثل “وحدات عمل” يمكن تشغيلها بالتوازي. عندما يقوم تطبيق ما بإرسال مهام إلى وحدة المعالجة المركزية، يتم توزيعها على هذه الخيوط، مما يتيح للمعالج إنجاز مهام متعددة في نفس اللحظة.

على سبيل المثال: يمكنك تشغيل لعبة، وفي الوقت نفسه الاستماع إلى الموسيقى وتصفح الإنترنت، وكل هذه العمليات تتم عبر عدة خيوط.

المهام أحادية الخيط مقابل المهام متعددة الخيوط

- المهام أحادية الخيط (Single-threaded tasks): مثل بعض الألعاب أو تطبيقات التصميم ثلاثي الأبعاد التي تعتمد على سرعة نواة واحدة. هنا، يفضل أن يكون لديك معالج بتردد عالٍ وعدد قليل من الأنوية القوية.

- المهام متعددة الخيوط (Multi-threaded tasks): مثل عمليات الرندر (Rendering) أو ضغط الفيديو، والتي يمكن تقسيمها إلى عدة مهام صغيرة تعمل بالتوازي. في هذه الحالة، يستفيد المعالج ذو عدد الأنوية والخيوط الكبير مثل AMD Threadripper من أداء أفضل.

العلاقة بين النوى والخيوط

عادةً، كل نواة تدعم خيطين، لكن الأداء لا يتضاعف بالضرورة إلى الضعف. الخيوط تحسن الكفاءة وتزيد من القدرة على تعدد المهام، لكنها لا تعوض عن قوة النواة نفسها. لذا، عند اختيار معالج جديد، من المهم الموازنة بين عدد الأنوية، عدد الخيوط، و سرعة التردد حسب نوع الاستخدام.

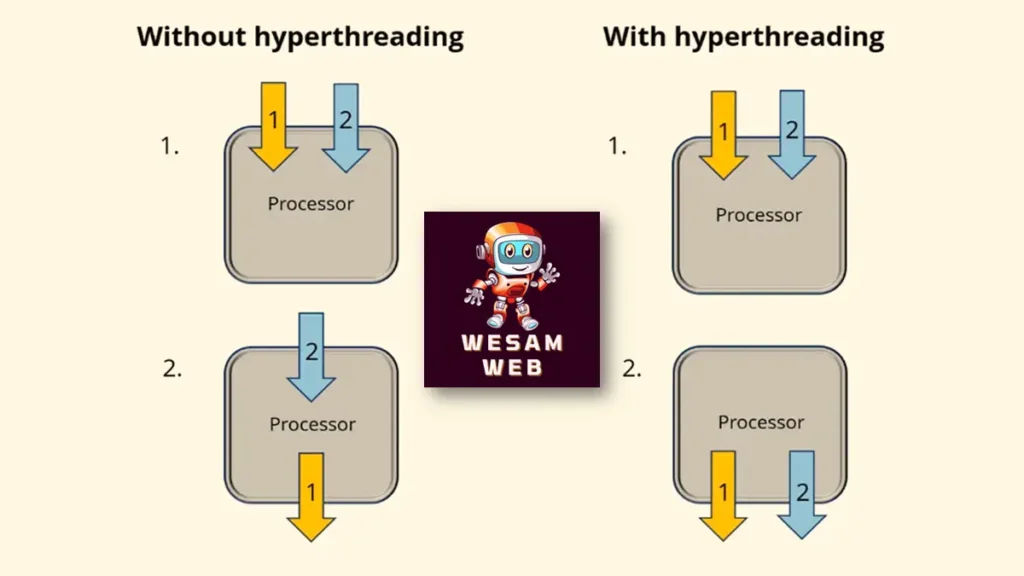

ما هو Hyper-Threading أو SMT في المعالج (CPU)؟

تقنية المعالجة الفائقة (Hyper-Threading) في معالجات Intel وميزة تعدد الخيوط المتزامن (SMT – Simultaneous Multi-Threading) في معالجات AMD تهدفان إلى مضاعفة كفاءة المعالج. تعتمد هذه التقنيات على جعل كل نواة مادية (Physical Core) تعمل كما لو كانت نواتين افتراضيتين (Logical Cores)، بحيث تتمكن من تشغيل خيطين (Threads) في الوقت نفسه بدلاً من خيط واحد.

كيف تعمل التقنية؟

عند تشغيل برنامج أو لعبة، يقوم المعالج بتنفيذ سلسلة من التعليمات عبر الخيوط. في المعالجات التقليدية، تعالج النواة خيطًا واحدًا فقط في وقت محدد. أما مع Hyper-Threading أو SMT، يتم الاستفادة من الأجزاء غير المستغلة داخل النواة لتشغيل خيط إضافي. هذا يعني أن المعالج يمكنه معالجة تعليمات أكثر في نفس اللحظة، ما يؤدي إلى تحسين الأداء العام وكفاءة استغلال موارد وحدة المعالجة.

المعالجات الداعمة للتقنية

- معظم المعالجات الحديثة تدعم هذه الخاصية وتستطيع تشغيل خيطين لكل نواة.

- بعض المعالجات الاقتصادية، مثل سلسلة Intel Celeron أو AMD Ryzen 3، لا تدعمها وتعمل بخيط واحد لكل نواة فقط.

- في بعض الحالات، تقوم الشركات مثل Intel بتعطيل Hyper-Threading عمدًا في فئات معينة من المعالجات لأسباب تتعلق بتجزئة السوق (Market Segmentation). لذلك، من المهم قبل شراء أي معالج مراجعة قسم عدد الأنوية والخيوط في المواصفات.

تأثير التقنية على الأداء

تشغيل الخيوط الإضافية لا يضاعف الأداء إلى 100%، لكنه قد يمنح زيادة تقارب 30% – 50% في بعض التطبيقات التي تستفيد من المعالجة المتوازية، مثل:

- تحرير الفيديو.

- برامج النمذجة والتصيير ثلاثي الأبعاد (3D Rendering).

- تشغيل عدة برامج في وقت واحد.

أما التطبيقات التي تعتمد على قوة نواة واحدة فقط (Single-threaded tasks)، مثل بعض الألعاب، فلن تستفيد كثيرًا من Hyper-Threading أو SMT.

دور المعالج (CPU) في الألعاب

تم تصميم ألعاب الكمبيوتر في البداية للعمل على الأنظمة أحادية النواة، وذلك قبل ظهور المعالجات متعددة النوى. لكن مع إطلاق شركة AMD لأول معالج ثنائي النواة في عام 2005، ثم تتابع ظهور المعالجات رباعية النوى والسداسية والثمانية، أصبح بالإمكان الاستفادة من النوى الإضافية في معالجة التعليمات وتنفيذ المهام المتعددة في وقت واحد، وهو ما أحدث نقلة كبيرة في أداء الألعاب.

ومع تطور متطلبات الألعاب الحديثة، أصبح من الضروري لكل لاعب اختيار وحدة معالجة مركزية ومعالج رسوميات متوافقين ومتوازنين. فلا يمكن للبطاقة الرسومية أن تقدم كامل إمكاناتها إذا كان أداء المعالج ضعيفًا أو بطيئًا في تنفيذ الأوامر. وبالمثل، فإن قوة المعالج العالية لن تكون فعالة إذا كانت البطاقة الرسومية محدودة الإمكانات.

في هذه الحالة تظهر مشكلة تعرف باسم عنق الزجاجة، وهي التي تحدث عندما يعيق أحد المكوّنين الآخر عن تقديم أقصى أداء. فإذا كان المعالج هو الأبطأ، فلن تستفيد البطاقة الرسومية من كامل قدراتها. أما إذا كانت البطاقة الرسومية ضعيفة، فلن يضيف المعالج القوي قيمة حقيقية لأداء الألعاب. ولهذا السبب، فإن التوازن بين المعالج والبطاقة الرسومية يعد من أهم العوامل التي تحدد تجربة اللعب وجودتها.

ما هو عنق الزجاجة Bottleneck في المعالج (CPU)؟

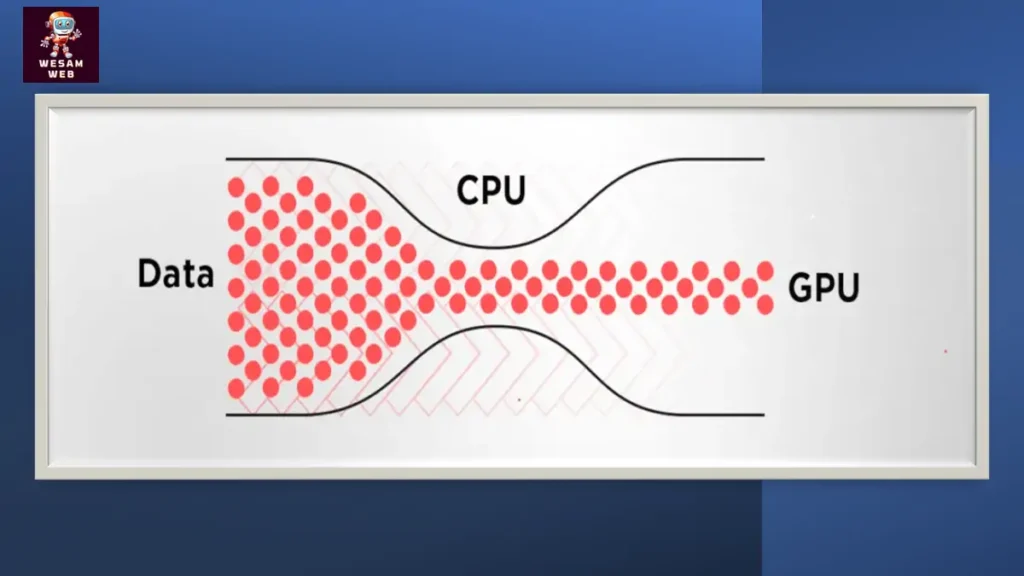

في أجهزة الكمبيوتر، يعرف عنق الزجاجة (Bottleneck) على أنه المكون الذي يحد من الأداء نتيجة اختلاف القدرات القصوى بين عنصرين من مكونات الجهاز. فعلى سبيل المثال، إذا كانت بطاقة الرسومات تستقبل التعليمات بشكل أسرع مما تستطيع وحدة المعالجة المركزية (CPU) تقديمه، ستظل البطاقة في حالة خمول بانتظار التعليمات التالية، وهو ما يؤدي إلى انخفاض معدل الإطارات أثناء التشغيل. في هذه الحالة يكون أداء الرسومات مقيدًا بقدرات المعالج.

الأمر قد يحدث بالعكس أيضًا، فإذا كان المعالج قويًا ويقوم بإرسال التعليمات أسرع مما تستطيع بطاقة الرسومات معالجته، فإن قوة المعالج تُهدر لأنه مقيد بضعف أداء البطاقة. ولهذا السبب فإن التوازن بين المعالج المركزي ومعالج الرسومات يعد عاملًا أساسيًا للحصول على أداء سلس ومستقر.

النظام المتوازن هو الذي لا يخلق فيه أي مكون اختناقًا يؤثر على العمليات المطلوبة من المستخدم. هذا التوازن يضمن تجربة أفضل دون تحميل زائد على المعالج أو البطاقة الرسومية أو حتى الاستفادة منهما بشكل أقل من قدراتهما الحقيقية. وباختصار، التوازن بين مكونات النظام هو ما يحدد جودة تجربة الاستخدام.

إرساء نظام متوازن بين وحدة الرسومات والمعالج (CPU)

عندما يتعلق الأمر بالألعاب أو معالجة الرسومات، فإن تأثير قوة المعالج على تحسين جودة تجربة اللعب للمستخدم سيكون ملحوظًا إذا كان هناك تنسيق وثيق بين وحدة الرسومات والمعالج؛ بالإضافة إلى ذلك، يعد نوع اللعبة وطرازها عاملين مهمين في اختيار الأجهزة.

ربما لا يزال من الممكن استخدام وحدات المعالجة المركزية رباعية النواة لتشغيل العديد من الألعاب، ومع ذلك، ستوفر المعالجات السداسية أو أكثر طريقة لعب أكثر سلاسة.

تعتبر الآن وحدات المعالجة المركزية متعددة النواة مطلوبة لأي جهاز ألعاب يلعب ألعاب إطلاق النار من منظور الشخص الأول (FPS) أو ألعاب متعددة اللاعبين عبر الإنترنت.

ولإنشاء نظام متوازن، يجب الانتباه إلى مجموعة من العوامل الأساسية:

- لا يمكن تحقيق تجربة لعب مثالية فقط عبر شراء أقوى معالج أو أقوى بطاقة رسومية بشكل منفصل، بل يجب أن يكون هناك توافق بينهما.

- عنق الزجاجة لا يرتبط بجودة المكونات أو قدمها بالضرورة، بل بكيفية تفاعلها وأدائها معًا.

- التوازن بين المكونات مهم سواء في الأنظمة المتقدمة أو الأجهزة ذات المواصفات المتوسطة والمنخفضة.

- على الرغم من أن عنق الزجاجة يظهر غالبًا بين المعالج وبطاقة الرسومات، إلا أن التنسيق بين هذين المكونين يظل العامل الأكثر تأثيرًا في تجنب هذه المشكلة.

ما هي معاني الحروف (لمعالجات Intel و AMD)؟

تضع شركتا Intel و AMD حروفًا ورموزًا بعد أسماء أو أرقام المعالجات للدلالة على خصائصها ومميزاتها، مثل دعم كسر السرعة، أو كفاءة استهلاك الطاقة، أو نوع الاستخدام المستهدف (مكتبي، محمول، ألعاب، أو محطات عمل). هذه الحروف تسهل على المستخدم فهم قدرات المعالج بسرعة واختيار الأنسب له.

إليك جدول يجمع أغلب الحروف (لمعالجات Intel و AMD):

| الحرف | الشرح |

|---|---|

| معنى حرف (K) في المعالج | خاص بمعالجات Intel، يشير إلى دعم كسر السرعة (Unlocked Multiplier) لزيادة الأداء. |

| معنى حرف (F) في المعالج | معالجات Intel التي لا تحتوي على بطاقة رسومات مدمجة (تحتاج GPU خارجي). |

| معنى حرف (KF) في المعالج | معالجات Intel تدعم كسر السرعة ولكن بدون رسومات مدمجة. |

| معنى حرف (X) في المعالج | في Intel يشير إلى Extreme Edition وهي أقوى الإصدارات للأداء العالي جدًا. |

| معنى حرف (XE) في المعالج | يرمز إلى Extreme Edition في معالجات Intel مع إمكانيات فائقة لمحطات العمل. |

| معنى حرف (T) في المعالج | خاص بـ Intel، يشير إلى استهلاك طاقة منخفض مع ترددات أقل. |

| معنى حرف (S) في المعالج | إصدارات خاصة من Intel عادةً بتردد أعلى وأداء أفضل من النسخة الأساسية. |

| معنى حرف (H) في المعالج | في Intel و AMD يُستخدم للحواسيب المحمولة ذات الأداء العالي (للألعاب والعمل المكثف). |

| معنى حرف (HK) في المعالج | معالجات Intel محمولة عالية الأداء مع دعم كسر السرعة. |

| معنى حرف (HQ) في المعالج | معالجات Intel محمولة متعددة الأنوية (Quad Core) عالية الأداء. |

| معنى حرف (U) في المعالج | في Intel و AMD يشير إلى Ultra-low Power أي معالجات محمولة باستهلاك طاقة منخفض. |

| معنى حرف (Y) في المعالج | في Intel يرمز إلى معالجات محمولة موفرة جدًا للطاقة للأجهزة الصغيرة والنحيفة. |

| معنى حرف (P) في المعالج | معالجات Intel لا تحتوي على رسومات مدمجة (قديمة نسبيًا). |

| معنى حرف (G) في المعالج | معالجات Intel أو AMD مزودة بـ رسومات مدمجة قوية (Intel Iris / Radeon Vega). |

| معنى حرف (M) في المعالج | في Intel يرمز إلى Mobile أي مخصص للحواسيب المحمولة. |

| معنى حرف (E) في المعالج | معالجات Intel للأجهزة المدمجة Embedded أو استهلاك منخفض. |

| معنى حرف (L) في المعالج | يشير إلى Low Power في بعض معالجات Intel القديمة. |

| معنى حرف (Q) في المعالج | في Intel يرمز إلى Quad Core أي معالج بأربع أنوية. |

| معنى حرف (vPro) في المعالج | خاصية في Intel موجهة للشركات مع دعم الأمان والإدارة عن بُعد. |

| معنى حرف (Ryzen X) في المعالج | يشير إلى أداء أعلى وBoost Clock أسرع مقارنة بالإصدارات العادية. |

| معنى حرف (Ryzen XT) في المعالج | نسخة محسنة من Ryzen X مع زيادة طفيفة في الأداء. |

| معنى حرف (Ryzen G) في المعالج | يحتوي على رسومات Radeon Vega مدمجة. |

| معنى حرف (Ryzen GE) في المعالج | معالجات Ryzen رسومية مدمجة مع كفاءة طاقة أعلى. |

| معنى حرف (Ryzen H) في المعالج | معالجات AMD محمولة عالية الأداء للألعاب. |

| معنى حرف (Ryzen HS) في المعالج | نسخة من Ryzen H باستهلاك طاقة أقل مع أداء شبه مماثل. |

| معنى حرف (Ryzen HX) في المعالج | أعلى أداء في سلسلة Ryzen المحمولة، موجهة للألعاب الاحترافية. |

| معنى حرف (Ryzen U) في المعالج | معالجات AMD المحمولة باستهلاك طاقة منخفض (Ultra Efficient). |

| معنى حرف (Ryzen PRO) في المعالج | موجه للشركات مع مزايا أمان وموثوقية إضافية. |

| معنى حرف (Threadripper WX) في المعالج | يشير إلى معالجات AMD Ryzen Threadripper الموجهة لمحطات العمل. |

في الختام

يمثل المعالج (CPU) العقل المدبر لأي جهاز كمبيوتر أو نظام إلكتروني، فهو الذي يقوم بتنفيذ التعليمات وإدارة العمليات بدقة متناهية. من خلال سرعته وبنيته وعدد أنويته، يحدد المعالج المستوى العام للأداء والقدرة على الاستجابة لمختلف المهام.

ومع التطور المستمر في تقنيات المعالجات، أصبحنا نشهد انتقالًا من الأنظمة أحادية النواة إلى المعالجات متعددة النوى، ثم إلى البنى المعمارية المتقدمة مثل ARM وx86-64، والتي غيرت شكل الحوسبة ووسعت نطاق الاستخدامات من الهواتف الذكية إلى أقوى الخوادم.

إن فهم دور المعالج ومكوناته لا يساعد فقط على اختيار الجهاز المناسب، بل يمنح المستخدم وعيًا بكيفية تحقيق التوازن بين المعالج وباقي المكونات، مثل بطاقة الرسومات والذاكرة. وهذا الوعي هو ما يضمن تجربة سلسة ومستقرة سواء في العمل، الترفيه، أو حتى في بيئات الحوسبة المتقدمة.